¿En qué se parecen una búsqueda en Google y un vaso de agua con hielo?

Además, nuestras recomendaciones y vacantes

Encuentra las recomendaciones del equipo y nuestras vacantes más abajo ⬇️

¿Qué tienen en común una búsqueda en Google y un vaso de agua con hielo? Por Mariano Morera

Una breve historia de ciencia y tecnología

Si sabes de qué hablo con tan sólo leer el título, eres un “nerd” como yo y espero que disfrutes de la lectura, aún entendiendo que podrías seguir con tu “scroll” en otro lado. Si crees que sabes de lo que hablo o el título simplemente te intriga, la probabilidad de leer el artículo hasta el final será más alta; por tanto, y según los conceptos que vamos a tratar, tengo confianza en que la mayoría de las personas leerán el artículo hasta el final.

Mi nombre es Mariano Morera y trabajo como Tech Product Manager en Igeneris, donde ayudamos a nuestros clientes a dar vida soluciones innovadoras desde su conceptualización hasta su lanzamiento al mercado o integración con otras unidades de negocio, y en este artículo vamos a hacer un repaso a los conceptos de entropía y el bit para concluir con reflexiones que aplican a nuestro día a día.

La teoría de la información de Shannon

Bell Labs — oficinas de Nokia; New Jersey, 1948.

Claude E. Shannon presenta un estudio sobre lo que se denominaría ‘teoría de la información’ consistente en un razonamiento matemático sobre la posibilidad de medir, procesar, transmitir y almacenar mensajes entre dos entidades, resultando en una nueva partícula fundamental para la medida de la información denominada ‘bit’. Shannon, proponía -y acabaría demostrando en los próximos años junto con W. Weaver- que cualquier mensaje es susceptible de decodificarse independientemente de su formato para transmitirse entre emisor y receptor. Hoy en día, el trabajo de Shannon se emplea para el desarrollo de múltiples tecnologías como los canales de comunicación (teléfono, TV, etc.), transmisión de archivos, o una búsqueda en internet; y participa en otras ramas del estudio científico como los agujeros negros.

En un plano más abstracto que las aplicaciones que vemos hoy en día, y en los términos que refieren a este artículo, podemos definir el bit como la unidad mínima de información que se utiliza para representar la contraposición entre dos valores (0 y 1, true o false, etc.); o a través de palabras del matemático George Miller — “la cantidad de información que necesitamos para tomar una decisión entre dos alternativas con el mismo grado de probabilidad”.

En el desarrollo de las ecuaciones de Shannon, éste toma la información como una magnitud física utilizando ecuaciones desarrolladas en los años anteriores y siglo XIX, resultando en la idea de que la información de un mensaje se podría calcular por un “método de configuraciones probables”, teniendo en cuenta que no todas las preguntas que le podemos realizar a una emisor del mensaje -sea una persona o una máquina- ni todas las respuestas contienen la misma información.

Para entender mejor el razonamiento detrás de la teoría, vamos a utilizar un ejemplo del funcionamiento del bit. Tomemos como muestra el conjunto de planetas del sistema solar, e imaginemos que quieres adivinar cuál es mi planeta favorito. Podrías hacerme dos tipos de pregunta:

¿Tu planeta favorito termina en “O”? Tanto si te dijera que sí como si te respondiera que no, te estaría aportando la misma información dado que hay 4 planetas que terminan en O y otros 4 que no, por lo que según la aplicación de la fórmula esta respuesta nos estaría aportando 1 bit de información.

¿Tu planeta favorito está compuesto en su mayoría por agua? Si te respondiera que sí, pasaríamos de 8 candidatos a 1 con tan sólo una pregunta, por lo que esta respuesta te aporta más información que la anterior — en concreto 3 bits siguiendo la misma ecuación.

En conclusión, los aportes de Shannon a mediados del siglo XX -y otros coetáneos- en el campo de las ciencias de la información sentarían los cimientos del desarrollo de nuevas tecnologías que han permitido alcanzar el mayor grado de productividad e innovación de la historia del ser humano dando forma a las eras de la tecnología, información, y conocimiento.

Si quieres explorar más conceptos “nerds” sobre cómo se creó internet o el funcionamiento del protocolo HTTP te recomiendo que escuches el capítulo 9 del podcast de Igeneris de mi compañera Hajar.

El “inestimable” destino de un cubo de hielo

Calle Larra 12 — oficina de Igeneris; Madrid, 2023.

En estas fechas en las que estamos todos de vuelta, aún con las lluvias intermitentes en la comunidad de Madrid, seguimos tomando un refrescante vaso de agua con hielo en los descansos, charlas o comidas — qué elixir.

El siglo anterior a Shannon, en plena revolución industrial y aún residentes en la visión atómica y de la materia continua clásica, Carnot y Clausius comenzarían el desarrollo de las leyes de la termodinámica que describen las características fundamentales que componen los sistemas de calor para facilitar el estudio del comportamiento de la temperatura y la energía. De los tres principios que se elaborarían en los años consiguientes dando forma a estas leyes, nos centraremos en el segundo: la cantidad de entropía del universo tiende a incrementarse en el tiempo.

Vale, espera, me suena de alguna película pero ¿qué es la entropía? ¿y qué tiene esto que ver con un vaso de agua o internet? Tras repasar varias definiciones, considero que la siguiente es la más inteligible y actualizada: la entropía es una magnitud física que mide el número de micro estados compatibles con el macro en un sistema en equilibrio y su comportamiento al aplicar calor.

El concepto de entropía se relaciona con la teoría de información porque se utiliza para medir el grado de organización -e incertidumbre- de un sistema. Se dice que un sistema altamente distribuido al azar tiene alta entropía, y que esta es una tendencia natural que observamos en muchos casos cotidianos como un vaso de agua con hielo o en el propio universo.

Consideremos para este ejemplo un vaso de agua que presenta una distribución ordenada en su estado líquido habitual, frente al estado gaseoso que se puede mezclar con mayor cantidad de partículas en el aire; y un cubo de hielo aún más frente a los estados líquidos y gaseosos. Al aplicar calor, el cubo de hielo se transforma en estado líquido, y éste último en estado gaseoso — y esto que nos resulta obvio pero no se pudo explicar físicamente durante el periodo de Carnot y Clausius, se demostraría matemáticamente por Boltzmann empleando millones de configuraciones para reforzar este principio y determinar la “dirección del calor” — o del tiempo.

En conclusión, el resultado de los experimentos concluyeron que la secuencia de estados sólido, líquido, y gaseoso del agua respondían a la configuración “inespecífica” o de micro estados más probable, y esto es una tendencia natural que se observa en el universo.

Y como diría Sheldon Cooper en un momento como este:

¿Y qué tiene esto que ver con la teoría de la información o el mundo digital de hoy en día? Introducidos los conceptos clave de bit y entropía, y con alguna confianza de que se entienda o intuya su relación en este punto, vamos a tratar de desgranarlo y responderlo en las siguientes conclusiones o reflexiones.

Donde hay incertidumbre, hay certeza

Lo cierto es que la entropía no era desconocida para Shannon y, de hecho, está íntimamente relacionada con la elaboración de su teoría utilizándose para medir el grado de “desorden” o incertidumbre de un sistema. Como indicábamos anteriormente, la entropía tiene en cuenta el sumatorio de configuraciones probables y la teoría de la información necesita recoger la probabilidad de mensajes y respuestas de una transmisión en sus cálculos.

Por otro lado, durante la época de Carnot y Clausius, algunos fenómenos como las partículas sub-atómicas aún no se podían explicar desde la física, por lo que sería años más tarde Boltzmann, y posteriormente M. Plank, así como el resto de hitos científicos que sucedieron en la primera mitad del siglo XX, quienes darían forma al conocimiento científico que ha configurado el modelo mental de occidente en los últimos siglos, y ha provocado el desarrollo de innovaciones tecnológicas cotidianas como el móvil o acceso a internet, algo que para las nuevas generaciones es incluso nativo.

Ahora, entendiendo la relación de naturaleza probabilística entre entropía e información que pretendo brindar en este artículo -así como la metáfora del vaso de agua e internet, o las leyes de la física clásica contenidas en una manzana-, me gustaría reflexionar sobre nuestra relación con la incertidumbre en los procesos de generación de conocimiento decodificando algunas cuestiones que nos encontramos en nuestro día a día.

En primer lugar, intentemos representar el proceso mecánico de generación de conocimiento con el siguiente gráfico:

Tal y como se observa en el gráfico, el proceso de generación de conocimiento pasa por las fases de colección de datos, procesamiento de los datos en información, y generación conocimiento accionable en base a conexiones. Es por ello que las organizaciones invierten sus recursos en diseñar y experimentar con procesos de ingesta, transformación y visualización de datos para generar conocimiento y obtener insights — hoy en día plataformas como Palantir Foundry son capaces de “minar” complejos procesos operativos cubriendo todos los aspectos de ETL.

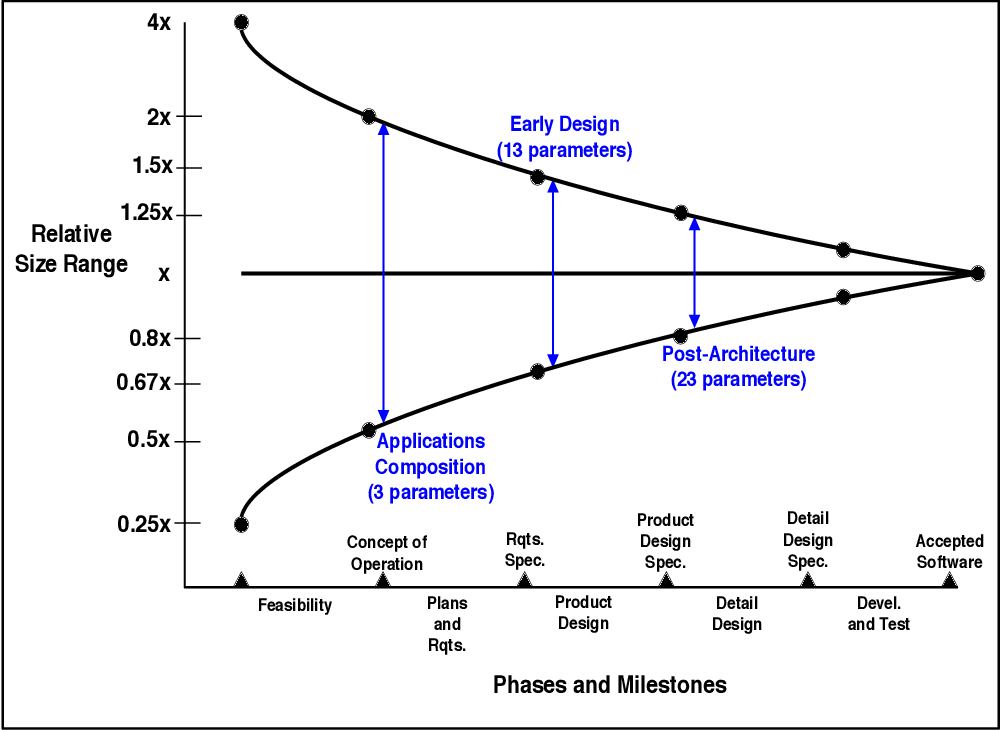

En segundo lugar, en un plano más abstracto que tiene lugar durante el proceso creativo de construcción de productos o servicios digitales desde cero, con carácter previo a la colección de datos o información estructurada se suele realizar una toma de requisitos o especificaciones. Para explicar a nuestros clientes cómo funcionan las primeras fases de la creación de un producto digital, a menudo utilizo el denominado ‘cono de incertidumbre’ definido por Barry Boehm que describe la evolución de la medida de incertidumbre durante la realización de un proyecto de desarrollo software representado en la siguiente figura:

Si consideramos la creación de software a medida como una actividad de generación de conocimiento en la organización -teniendo en cuenta ésta desde la conceptualización del producto o servicio-, entendemos que necesitamos pasar por una serie de fases para estructurar la información y generar los parámetros que van a configurar el conocimiento del proyecto. La idea es que la incertidumbre de un proyecto se reduce con el paso del tiempo, mejorando la progresiva o iterativa toma de decisiones sobre el producto o servicio, gracias a seguir una secuencia lógica de fases y especificaciones -o micro estados- que disminuyen la probabilidad de desviación con respecto a los objetivos determinados. Probabilidad, incertidumbre, ¿te suena? — y ciertamente, este tipo de procesos toman un pulso a la naturaleza de la entropía.

Por último, construyendo sobre la idea anterior, considero que es clave en las primeras fases de proyectos de creación de ventures o nuevos negocios de base digital, entender seriamente los por qué y hacer buenas preguntas para despejar la ecuación de lo que se pretende conseguir con el proyecto. Tal y como explica mi amigo Gilbert en su libro ‘People skills for analytical thinkers’, los pensadores analíticos -generalmente ligados a los perfiles técnicos -entienden muy bien los qué y cómo, por lo que son capaces de construir herramientas sofisticadas que nadie usa — si no se emplean la empatía y el sentido común durante el proceso creativo. Si acudimos al ejemplo del capítulo de Shannon, una buena pregunta nos aporta más información, y por tendencia natural o entrópica, la suma de configuraciones posibles para la resolución del problema incrementa con el tiempo sumando complejidad por lo que más vale hacer buenas preguntas desde el principio.

Comprender el contexto de la audiencia y los objetivos que se esperan obtener del desarrollo de un proyecto de estas características es clave porque reduce la incertidumbre del mensaje que queremos “descifrar” de nuestros stakeholders. El mundo se torna cada vez más complejo y competitivo, hacia una sociedad global donde los datos son la gasolina de la transformación y la información está democratizada por lo que la única ventaja competitiva es el conocimiento.

Ahora, ¿cómo podemos medir el conocimiento? ¿Es siquiera posible? Estas cuestiones, probablemente las abordaremos en otro momento.

Recomendaciones 🔥

🎧 Javier Amador, Project Manager en Igeneris, te recomienda escuchar: Las CLAVES del GO TO MARKET de FACTORIAL. Un podcast interesante para dimensionar equipos de venta en modelos B2B para scale up phase. También, para ordenar el equipo, trabajo, tareas y objetivos en etapas más incipientes.

📰 Leopoldo Rojas, Tech Product Lead en Igeneris, te recomienda leer: Mahou ofrecerá productos financieros a bares y restaurantes. Un artículo interesante porque muestra la intención de Mahou de ampliar y diversificar su modelo de negocio: "queremos pasar de ser una cervecera a una cervecera que dé servicios".

#JoinIgeneris 🤝

Igeneris sigue creciendo. Si estás interesado en alguna de nuestras ofertas o conoces a alguien que pueda encajar, ¡no dudes en contactar con nosotros!

En la oficina de Madrid buscamos:

En la oficina de México buscamos: